Cuando se habla del nivel de éxito o influencia en Twitter, la mayoría de los usuarios de esta red social lo asocia inmediatamente a la idea simplista de tener muchos seguidores, un tremendo error del que ya hemos hablado varias veces porque, como puedes ver en este post, esta cifra, por si sola, no dice absolutamente nada sobre tu influencia real en Twitter. Algo que reconocen incluso los propios fundadores de Twitter.

Esto es así, sobre todo, por las técnicas de dudosa ética con las que la enorme mayoría de usuarios de Twitter ceban artificialmente sus cuentas, un tiempo perdido porque la calidad de sus seguidores es tan mala (interactúan tan poco) que resulta muy cuestionable que el esfuerzo invertido sirva realmente para algo que no sea presumir de un gran número de seguidores, sin contar que para muchos tuiteros es una buena razón para no hacerse seguidores de una cuenta que aplica estas prácticas.

Así que mi consejo es muy simple: si de verdad quieres aprovechar tu cuenta Twitter para algo útil, incluso sacarle algún partido a nivel profesional, céntrate en desarrollar una actividad que obtenga resultados y no en hacer el paripé con un montón de gente (y/o cuentas falsas) que básicamente pasan de ti. Y esto pasa por lo que tantas veces habrá leído ya: usar Twitter aportando valor a tu comunidad.

Así conseguirás seguidores “de verdad”, gente que realmente aprecie tus aportaciones y que por tanto interactuará contigo, gente con la que tú también interactuarás y a la que, llegado un momento dado, incluso te puedes plantear venderle algo si has generado suficiente confianza para ello. Y además, de paso, le estarás dando un buen empujón a tu marca personal.

Sólo podrás saber si eres influyente en Twitter si sabes medir correctamente

Para saber si lo estás haciendo bien has de medirlo de una manera correcta y eso pasa por usar criterios con un poco más de sentido que el dato hueco de tus seguidores en Twitter.

Las métricas válidas son las relacionadas con la influencia que logramos en Twitter, es decir, las que miden el impacto de nuestros tweet en diferentes vertientes.

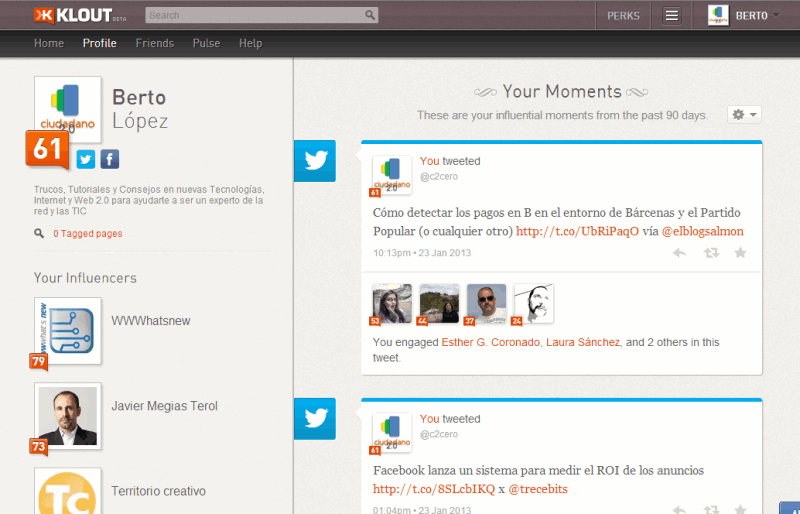

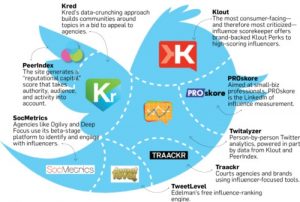

En torno al concepto de la influencia han nacido toda una serie de herramientas como Klouto PeerIndex, las cuales se basan en métricas como los retuits o las menciones para calcular unos índices de influencia que son mucho más representativos de la calidad nuestra cuenta Twitter que el número de seguidores.

En el caso de Klout, por ejemplo, usa fundamentalmente tres criterios: la cantidad de gente a la que influimos (es decir, número de seguidores), en qué medida conseguimos influirlos (retuits, menciones, comentarios, enlaces, etc.) y la relevancia o nivel de influencia de los propios seguidores. Cuanto mayor es el índice Klout, más atención estás recibiendo con tus tuits.

¿En qué te deberías fijar para medir tu influencia real en Twitter?

Usar una herramienta como Klout es una primera aproximación mucho más válida, aunque no perfecta, para medir el éxito real de tu cuenta Twitter, la calidad de tus acciones y la calidad de tus seguidores. De hecho, tanto Klout como PeerIndex no dejan de ser herramientas que reducen al final todo a un simple índice y que, además, han recibido duras críticas por sus detractores.

En cualquier caso, los criterios medibles son los que son, así que repasamos los más importantes, los cuales te van permitir evaluar bastante bien cuál es tu nivel real de éxito en Twitter.

1. Interacciones (retuits, favoritos, menciones, respuestas/conversaciones)

Estas interacciones son el criterio más obvio, tan obvio que no entiendo muy bien cómo Twitter no incluye un índice parecido al de Klout (que se basa en gran medida en las interacciones), junto con las tres métricas de tweets, seguidos y seguidores que se ven en la portada de los perfiles de Twitter.

Serían muy interesantes, por ejemplo, uno indicadores tan simples de retuits por mes (mediría el impacto en tus seguidores inmediatos) y otro que fuera este mismo número dividido entre el número de seguidores (mediría calidad de tus tuits y “el caso” que te hace tu comunidad de seguidores).

¿Cómo es posible que Twitter no ofrezca un simple cuadro con cosas tan simples? ¿Será porque temen tirar piedras contra su propio tejado al destapar con ello a la gran cantidad de vendedores de humo que pululan por Twitter?

2. Conversiones (clics, acciones, etc.)

Otro criterio muy importante son las “conversiones”, es decir, las veces que hayas logrado una acción por parte de un seguidor en Twitter (típicamente que haga clic en un enlace).

Esta métrica no solamente es útil para medir tu influencia (porque reflejará la confianza que tiene tu público en ti) sino que además resulta un feedback tremendamente útil (qué le gusta y qué no a tu público), aunque esto último relativiza también su valor como métrica para medir tu influencia.

En cualquier caso, un truco para medir el éxito de los tweets es usar acortadores de URLs para los tweets con enlace. Acortadores como bitlyque permiten crearte una cuenta con estadísticas del número de clics que ha recibido el enlace acortado con ellas.

Si usas herramientas para el encolamiento automático de tweets para enviarlos en horarios óptimos como Buffer (que recomiendo muy encarecidamente) ya tienes esta funcionalidad incorporada en la propia herramienta. Algo similar ocurre con la herramienta Twitterfeed que ya hemos recomendado en numerosas ocasiones para conseguir seguidores de calidad en Twitter.

3. En cuántas listas estás

Que alguien te incluya en una lista de Twitter es un reconocimiento a tus aportaciones. Por tanto, este sería otro indicador muy sencillo y claro de la calidad de una cuenta Twitter.

Aunque Twitter te permite ver el listado de las listas en las que figuras, no han tenido el pequeño detalle de visualizar en alguna parte el número exacto de listas y en nuestro caso, por ejemplo, que ya estamos en más de 200, pues se hace algo pesado contarlas una a una…

Pero, por suerte, hay herramientas como Twitonomy que te dicen esta cifra.

4. Número de #ff recibidos

Los Follow Friday son unas menciones de reconocimiento especial hechas por otros usuarios (usando los hashtags de #ff o #followfriday) que premian expresamente la calidad de las cuentas mencionadas. Normalmente son los usuarios más influyentes los que más #ff reciben. Así que resultan un indicador de calidad bastante interesante.

Aunque esta misma circunstancia también tiene su lado oscuro porque puede también ser un indicador bastante manipulable cuando lo usan grupos de tuiteros que se coordinan entre sí para hacerse mutuamente este tipo de reconocimientos para autopromocionarse.

5. Seguidores activos / inactivos / fake (falsos)

Una parte no despreciable de las cuentas Twitter son cuentas falsas o inactivas. Estas cuentas se pueden detectar con herramientas como Fake Followers Check (detecta cuentas falsas) o Twit Cleaner (detecta cuentas con determinados comportamientos “sospechosos”). De hecho, yo las uso para limpiar de vez en cuando la lista gente a la que seguimos porque regularmente se nos cuelan falsos seguidos (seguramente a través de herramientas que usan en API de Twitter).

En este sentido es interesante saber qué % de una cuenta Twitter son seguidores reales (auténticos y activos) ya que los falsos o inactivos no se pueden contabilizar como seguidores, son puro humo y no te ayudarán en nada para mejorar tu nivel influencia en Twitter.

¿Cómo medir con estas métricas?

Hay una increíble cantidad de herramientas de análisis y monitorización de Twitter, junto con una cantidad increíble de posts de las “X mejores herramientas de Y para Twitter”.

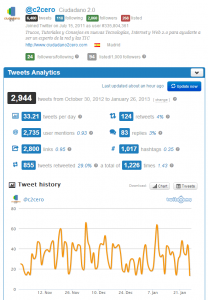

Entre esta jungla de información uno de los post que más me han gustado (y eso que es un listado muy cortito comparado con otros), y cuya lectura te recomiendo especialmente, es este post de 10 Herramientas de análisis y estadísticas visuales (en inglés). No todas me convencen, pero en cambio, algunas como Twitonomy (la descubrí gracias a este post) o TweetStats son muy recomendables.

En particular, Twitonomy me parece espectacular teniendo en cuenta que ofrece gratis un nivel de información y prestaciones que normalmente sólo se encuentran en herramientas de pago. Ya verás como con esta herramienta irás más que servido por mucho tiempo.

Concluyendo

No cabe duda de la importancia y del valor de Twitter como red social y como herramienta de comunicación y difusión, pero desgraciadamente también está llena de cosas que son humo como lo es la falacia de que el número seguidores refleja tu importancia o influencia en Twitter.

Sin embargo, si te quieres tomar esta red social en serio, verás que, bien usada, funciona muy bien. Pero para ello tienes que aprender a usar las métricas correctas para medir tus progresos y no autoengañarte creyendo que si consigues muchos seguidores a base de seguir a otros que te hacen un “follow back” estás progresando.

Lo que estás haciendo en este último caso es simplemente perder el tiempo.

Adicionalmente, con estas herramientas vas a aprender a conocer más a tu público ya que verás los horarios en que la mayoría interactúa, los temas que más les interesa y quiénes son sus abonados más activos.